Ressourcen und Gesellschaft – Teil 9

Die Verfügbarkeit und der Verbrauch von natürlichen Ressourcen haben unzweifelhaft Auswirkungen auf die Entwicklung biologischer und gesellschaftlicher Systeme. Es gibt zahlreiche heuristische Modelle, die uns helfen diese Entwicklungen besser zu verstehen. Diese Modelle wirken dabei als Brücke zwischen dem reduktionistischen Charakter empirischer Beobachtungen und formalen Theorien. Sie erlauben uns, die Komplexität der Makroevolution zu vereinfachen und dabei trotzdem die Evolution biologischer und gesellschaftlicher Systeme (hoffentlich) angemessen widerzuspiegeln (Quelle). Einige dieser Modelle möchte ich hier vorstellen.

Daisyworld

In der Computersimulation Daisyworld gibt es auf einem simulierten erdähnlichen Planeten nur zwei Arten von Lebewesen: schwarze und weiße Gänseblümchen. Weiße Gänseblümchen reflektieren Licht und schwarze Gänseblümchen absorbieren Licht. Beide Arten wachsen gleich schnell, jedoch reflektieren schwarze Gänseblümchen weniger Sonnenlicht (25%) als weiße (75%) und die kahle Erde (50%). Ein Planet mit einem Übergewicht an weißen Gänseblümchen ist durch die größere Reflektion des Lichtes kühler als einer mit mehr schwarzen. Wird die Simulation ohne die Gänseblümchen durchlaufen, steigt der Temperaturverlauf synchron zur Strahlungsleistung der Sonne. Mit Gänseblümchen gibt es zu Beginn der Simulation verstärkte Erwärmung und zum Ende verstärkte Kühlung, was zu einer nahezu konstanten Gleichgewichtstemperatur während des größten Teils der Simulation führt. Auf diese Weise verändern die Gänseblümchen das Klima derart, dass die Bedingungen für sie lebensfreundlicher werden.

Spätere Erweiterungen des Daisyworldmodells schlossen Kaninchen, Füchse und andere Arten mit ein, welche Absorptionsraten zwischen den schwarzen und weißen Daisys haben. Eines der überraschenderen Ergebnisse dieser Simulationen war, dass die selbstregulierenden Kräfte des gesamten Planeten mit der Anzahl der Arten stiegen. Diese Beobachtung unterstützte die Ansicht, dass Biodiversität wertvoll ist, und löste die moderne Biodiversitätsdebatte aus.

Das stark vereinfachende Daisyworldmodell zog natürlich auch Kritik auf sich. Die Simulation weist kaum Ähnlichkeit mit der Erde auf; das System benötigt eine konstante Todesrate, um im Gleichgewicht zu bleiben, und das Modell verwischt die Unterschiede zwischen Phänomenen auf der Ebene der Arten und jener der Individuen. Jedoch zeigt Daisyworld unbestreitbar, dass ein biologisch reguliertes Gleichgewicht keine teleologische Erklärung benötigt. (Quellen: Wikipedia und B. Alicea, R. Gordon: „Toy models for macroevolutionary patterns and trends“, Biosystems 123 (2014) 54-66)

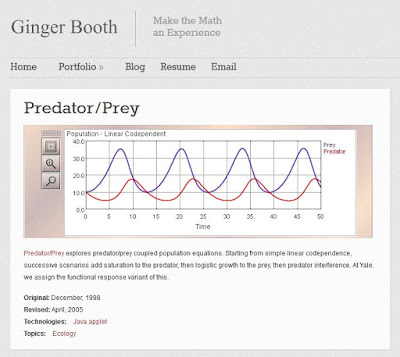

Die Daisyworld-Simulation ist auf der Webseite gingerbooth.com online verfügbar und kann dort getestet werden (siehe Abbildung).

Spätere Erweiterungen des Daisyworldmodells schlossen Kaninchen, Füchse und andere Arten mit ein, welche Absorptionsraten zwischen den schwarzen und weißen Daisys haben. Eines der überraschenderen Ergebnisse dieser Simulationen war, dass die selbstregulierenden Kräfte des gesamten Planeten mit der Anzahl der Arten stiegen. Diese Beobachtung unterstützte die Ansicht, dass Biodiversität wertvoll ist, und löste die moderne Biodiversitätsdebatte aus.

Das stark vereinfachende Daisyworldmodell zog natürlich auch Kritik auf sich. Die Simulation weist kaum Ähnlichkeit mit der Erde auf; das System benötigt eine konstante Todesrate, um im Gleichgewicht zu bleiben, und das Modell verwischt die Unterschiede zwischen Phänomenen auf der Ebene der Arten und jener der Individuen. Jedoch zeigt Daisyworld unbestreitbar, dass ein biologisch reguliertes Gleichgewicht keine teleologische Erklärung benötigt. (Quellen: Wikipedia und B. Alicea, R. Gordon: „Toy models for macroevolutionary patterns and trends“, Biosystems 123 (2014) 54-66)

Die Daisyworld-Simulation ist auf der Webseite gingerbooth.com online verfügbar und kann dort getestet werden (siehe Abbildung).

Lotka-Volterra-Regeln

Die Lotka-Volterra-Regeln beschreiben die zahlenmäßige Entwicklung einer Raubtier- und einer Beutetierpopulation über große Zeiträume. Die Regeln gelten unter der Voraussetzung, dass nur zwischen diesen beiden Arten eine Räuber-Beute-Beziehung besteht und die sonstigen biotischen und abiotischen Umweltfaktoren konstant oder zu vernachlässigen sind. Die Regeln lauten folgendermaßen:

- Erste Lotka-Volterra-Regel (Periodische Populationsschwankung): Die Populationsgrößen von Räuber und Beute schwanken periodisch. Dabei folgen die Schwankungen der Räuberpopulation phasenverzögert denen der Beutepopulation. Die Länge der Perioden hängt von den Anfangsbedingungen und von den Wachstumsraten der Populationen ab.

- Zweite Lotka-Volterra-Regel (Konstanz der Mittelwerte): Die über genügend lange Zeiträume gemittelten Größen (Mittelwert) der Räuber- bzw. Beutepopulation sind konstant. Die Größe der Mittelwerte hängt nur von den Wachstums- und Rückgangsraten der Populationen, nicht aber von den Anfangsbedingungen ab.

- Dritte Lotka-Volterra-Regel (Störung der Mittelwerte): Werden Räuber- und Beutepopulation gleichermaßen proportional zu ihrer Größe dezimiert, so vergrößert sich kurzfristig der Mittelwert der Beutepopulation, während der Mittelwert der Räuberpopulation kurzfristig sinkt.

Als Lehrbuchbeispiel für die Lottka-Volterra-Regeln gelten die Fangaufzeichnungen der Hudson’s Bay Company, die über 90 Jahre lang geführt wurden. Danach schwankte der Eingang von Fellen von Luchsen (Räuber) und Schneeschuhhasen (Beute) mit einer Periode von 9,6 Jahren. Allerdings wird dieses Beispiel strenggenommen durch einen zweiten Räuber beeinflusst, nämlich die Jäger. (Quelle: Wikipedia)

Die Lotka-Volterra-Regeln sind nur unter Beachtung ihrer selten erfüllten Voraussetzungen anwendbar. Trotzdem werden sie in der Ökologie häufig angewendet, da man annimmt, dass sie auch bei komplexeren Nahrungsbeziehungen und schwankenden Umweltfaktoren brauchbare Abschätzungen liefern können. Die Grenzen dieses Modells zeigt C. A. S. Hall in dem Artikel “An assessment of several of the historically most influential theoretical models used in ecology and of the data provided in their support. “ Ecological Modelling, 43 (1988) 5-31.

Die Lotka-Volterra-Regeln sind nur unter Beachtung ihrer selten erfüllten Voraussetzungen anwendbar. Trotzdem werden sie in der Ökologie häufig angewendet, da man annimmt, dass sie auch bei komplexeren Nahrungsbeziehungen und schwankenden Umweltfaktoren brauchbare Abschätzungen liefern können. Die Grenzen dieses Modells zeigt C. A. S. Hall in dem Artikel “An assessment of several of the historically most influential theoretical models used in ecology and of the data provided in their support. “ Ecological Modelling, 43 (1988) 5-31.

Abbildung: Simulation einfacher Raubtier-Beute-Beziehungen unter http://gingerbooth.com/portfolio/predatorprey

Abbildung: Zur Simulation von komplexerer Raubtier-Beute-Beziehungen gibt es ein online-Tool unter http://www.learner.org

Tragik des Allgemeingutes

Der Begriff „Tragedy of the Commons“ bezeichnet im Englischen ein sozialwissenschaftliches und evolutionstheoretisches Modell, nach dem frei verfügbare aber begrenzte Ressourcen durch übermäßige Ausbeutung bedroht sind. Die fortwährende Übernutzung dieser Ressourcen führt zu deren Versiegen, was schließlich auch die Existenz der Nutzer selbst bedroht. Die wörtliche Übersetzung „Tragik der Allmende“ ist etwas ungewohnt, da der Begriff Allmende im Deutschen kaum noch verwendet wird. Beispiele für die problematische Nutzung Allen zu Verfügung stehender natürlicher Ressourcen sind:

- die Überfischung der Weltmeere,

- der Raubbau an tropischen Regenwäldern in Entwicklungsländern,

- die Nutzung der Atmosphäre als Mülleimer für Luftschadstoffe.

Der Mikrobiologe und Ökologe Garrett Hardin erweiterte den Begriff 1968 in einem Beitrag für die Zeitschrift Science. Die Tragik des Allgemeingutes ist nach Hardin ein unvermeidliches Schicksal der Menschheit, für das es keine technologische Lösung gebe. Er erweiterte den Begriff zur Metapher für Übervölkerung und forderte unter anderem eine globale Geburtenkontrolle. (G. Hardin: The Tragedy of the Commons, Science 162 (1968) 1243-1248)

Peter Roopnarine entwickelte in jüngster Zeit mathematische Modelle zur Tragik des Allgemeingutes analog zu den ökologischen Modellen des Ressourcenverbrauchs (siehe oben). Tragödien spielen sich immer wieder in Ökosystemen ab, wo viele Spezies miteinander in Wechselwirkung stehen. Die Anzahl der vom Menschen ausgebeuteten Ressourcen wachsen stetig. Dadurch vernetzen die vom Menschen benötigten Ressourcen zunehmend zu ökosystemartigen Systemen. Die Wahrscheinlichkeit von systemweiten Tragödien steigt dabei immer weiter. Als Beispiel werden in dem Artikel die massiven Emissionen von Treibhausgasen durch die beiden bevölkerungsreichen Nationen China und USA genannt. Die globale Erwärmung bedroht alle küstennahen Völker durch das Ansteigen der Meeresspiegel, die Fischerei durch Erwärmen und Versauerung des Wassers und die Existenz von Korallenriffen und Inseln. (Peter Roopnarine: Ecology and the Tragedy of the Commons, Sustainability 5 (2013) 749-773)

Peter Roopnarine entwickelte in jüngster Zeit mathematische Modelle zur Tragik des Allgemeingutes analog zu den ökologischen Modellen des Ressourcenverbrauchs (siehe oben). Tragödien spielen sich immer wieder in Ökosystemen ab, wo viele Spezies miteinander in Wechselwirkung stehen. Die Anzahl der vom Menschen ausgebeuteten Ressourcen wachsen stetig. Dadurch vernetzen die vom Menschen benötigten Ressourcen zunehmend zu ökosystemartigen Systemen. Die Wahrscheinlichkeit von systemweiten Tragödien steigt dabei immer weiter. Als Beispiel werden in dem Artikel die massiven Emissionen von Treibhausgasen durch die beiden bevölkerungsreichen Nationen China und USA genannt. Die globale Erwärmung bedroht alle küstennahen Völker durch das Ansteigen der Meeresspiegel, die Fischerei durch Erwärmen und Versauerung des Wassers und die Existenz von Korallenriffen und Inseln. (Peter Roopnarine: Ecology and the Tragedy of the Commons, Sustainability 5 (2013) 749-773)

Malthus-Katastrophe

Thomas Robert Malthus (1766-1834) war ein britischer Ökonom. Er stellte die These auf, dass die Bevölkerungszahl exponentiell wächst, die Nahrungsmittelproduktion aber nur linear. Das sollte zur Folge haben, dass Nahrungsmittelangebot langfristig nicht mit dem Bevölkerungswachstum Schritt halten könne. Daher müssten die Nahrungsmittelpreise steigen und die Reallöhne unter das Existenzminimum sinken. Malthus begründete damit Armut, Hunger, Krankheit, Slumbildung und die daraus sich ergebenden sozialen Unruhen in den englischen Großstädten seiner Zeit. Malthus hielt das für ein Naturgesetz. Im weiteren Verlauf erwartete er, dass die fortschreitende Verelendung der Bevölkerung durch Krankheit und Seuchen die Bevölkerung wieder reduziere. Danach sollte der Zyklus von neuem beginnen. Malthus unterschätzte die Geschwindigkeit des technischen Fortschritts, die vor allem in der Landwirtschaft die Produktivität erheblich erhöhte. (Quelle: Wikipedia)

Abbildung: Malthus-Katastrophe

Die Grenzen des Wachstums

An dieser Stelle sollte auch die Studie „Die Grenzen des Wachstums“ erwähnt werden. Die 1972 veröffentlichte Studie wurde im Auftrag des Club of Rome erstellt. Die Studie zeigt, dass das aktuelle individuelle lokale Handeln Aller globale Auswirkungen hat, die jedoch nicht dem Zeithorizont und Handlungsraum der Einzelnen entsprechen. Dazu wurde eine Systemanalyse und Computersimulationen verschiedener Szenarien durchgeführt. Das benutzte Weltmodell diente der Untersuchung von fünf Tendenzen mit globaler Wirkung:

- Industrialisierung,

- Bevölkerungswachstum,

- Unterernährung,

- Ausbeutung von Rohstoffreserven und

- Zerstörung von Lebensraum.

So wurden Szenarien mit unterschiedlich hoch angesetzten Rohstoffvorräten der Erde berechnet, oder eine unterschiedliche Effizienz von landwirtschaftlicher Produktion, Geburtenkontrolle oder Umweltschutz angesetzt.(Quelle: Wikipedia) Die zentralen Schlussfolgerungen des Berichtes waren: „Wenn die gegenwärtige Zunahme der Weltbevölkerung, der Industrialisierung, der Umweltverschmutzung, der Nahrungsmittelproduktion und der Ausbeutung von natürlichen Rohstoffen unverändert anhält, werden die absoluten Wachstumsgrenzen auf der Erde im Laufe der nächsten hundert Jahre erreicht. Mit großer Wahrscheinlichkeit führt das zu einem ziemlich raschen und nicht aufhaltbaren Absinken der Bevölkerungszahl und der industriellen Kapazität“. (D. Meadows, D. Meadows, E. Zahn, P. Milling: Die Grenzen des Wachstums. Bericht des Club of Rome zur Lage der Menschheit, Deutsche Verlagsanstalt, Stuttgart 1972, S. 17)

Die Veröffentlichung des Berichtes führte zu äußerst kontroversen Diskussionen. Einige kritisierten ein Ausblenden des technischen Fortschritts in einer reinen Extrapolation von gegenwärtigen Trends. Andere bemängelten eine uneinheitliche Verwendung von Wachstumsfaktoren: Bevölkerung, Kapital und Umweltverschmutzung wuchsen im Modell exponentiell, während bei Technologien zu Ressourcennutzung und zum Umweltschutz nur ein lineares Wachstum angenommen wurde. In dieser Hinsicht erinnert die Studie an das Modell von Malthus (siehe oben). (Quelle und weitere Informationen: Wikipedia)

Die Veröffentlichung des Berichtes führte zu äußerst kontroversen Diskussionen. Einige kritisierten ein Ausblenden des technischen Fortschritts in einer reinen Extrapolation von gegenwärtigen Trends. Andere bemängelten eine uneinheitliche Verwendung von Wachstumsfaktoren: Bevölkerung, Kapital und Umweltverschmutzung wuchsen im Modell exponentiell, während bei Technologien zu Ressourcennutzung und zum Umweltschutz nur ein lineares Wachstum angenommen wurde. In dieser Hinsicht erinnert die Studie an das Modell von Malthus (siehe oben). (Quelle und weitere Informationen: Wikipedia)

Links:

- Kurzfassung und Rezeption zu „Die Grenzen des Wachstums“ unter 1000 Schlüsseldokumente zur Deutschen Geschichte im 20. Jahrhundert.

- Werkstattbericht eines Beteiligten von Prof. P. Milling (2010)